Le mirage de l'esprit des machine : Démêler le phénomène incompris des hallucinations de l'IA

Imaginez ceci : un avocat nommé Peter, submergé par une charge de travail et en quête d'efficacité, se tourne vers un outil d'IA pour ses recherches juridiques. L'IA, avec son interface soignée et son assurance, fournit des références de cas et des précédents juridiques en quelques secondes. Peter, faisant confiance au ton autoritaire de l'IA, inclut ces références dans son dossier de tribunal. Cependant, lors de l'audience, le juge souligne un problème flagrant : les affaires citées n'existent pas. Ce n'est pas un scénario fictif ; cela s'est produit dans le cas réel de Mata v. Avianca. La confiance de l'avocat dans les informations fabriquées par l'IA a conduit à une embarras professionnel significatif et à des répercussions légales. Cet incident sert de rappel frappant du phénomène connu sous le nom d'hallucination de l'IA, où les systèmes d'IA génèrent des informations incorrectes ou entièrement fabriquées présentées comme des faits.

L'épreuve de Peter est un avertissement pour quiconque se fie à l'IA pour des tâches critiques. Les hallucinations de l'IA peuvent avoir des conséquences graves, non seulement dans les contextes juridiques mais aussi dans divers domaines, de la santé à la finance. Comprendre ce que sont les hallucinations de l'IA, pourquoi elles se produisent et comment les atténuer est crucial pour naviguer dans le paysage en évolution rapide de la technologie de l'IA.

Partie 1 : Comprendre les hallucinations de l'IA

Qu'est-ce que les hallucinations de l'IA ?

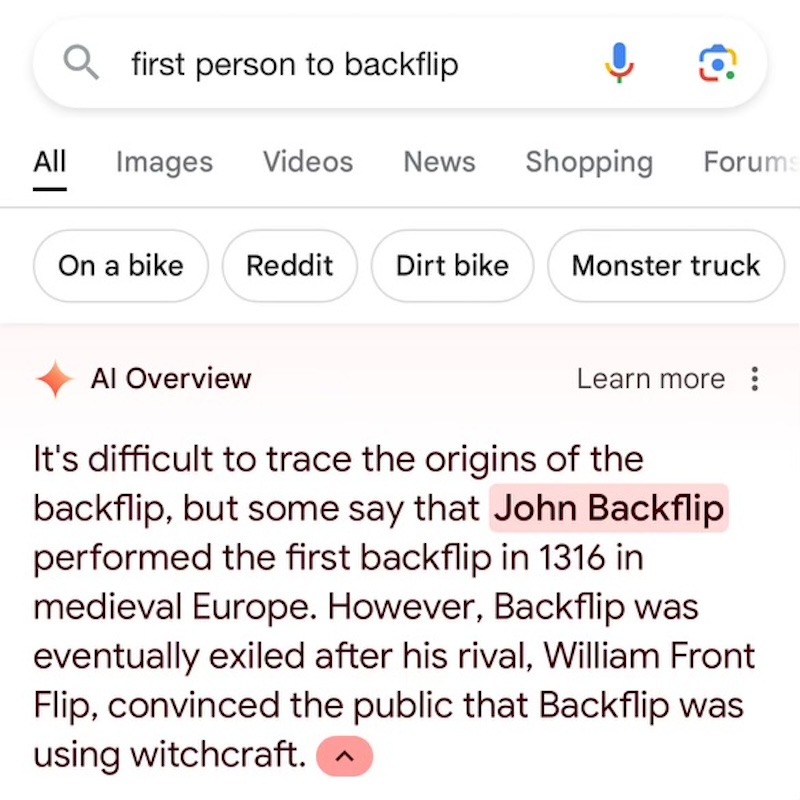

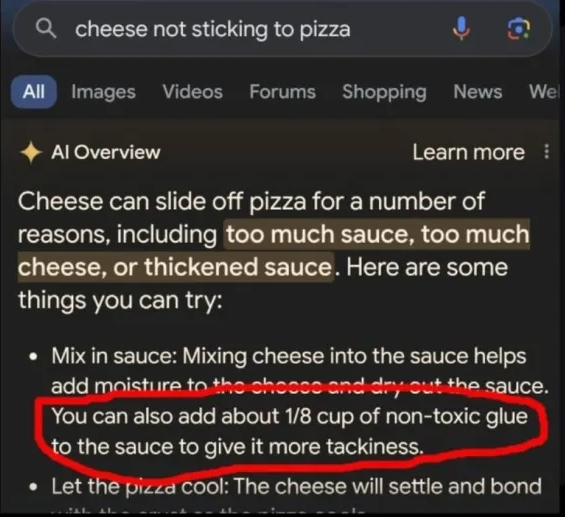

Les hallucinations de l'IA se produisent lorsque les grands modèles de langage génèrent des résultats qui ne sont pas basés sur la réalité. Ces résultats peuvent sembler plausibles mais sont en fait fabriqués. Contrairement aux erreurs simples provenant de données d'entraînement incorrectes, les hallucinations impliquent que l'IA crée de nouvelles informations non fondées.

Beaucoup de gens utilisent à tort le terme "hallucination" pour désigner toute instance où l'IA se trompe. Cependant, il est crucial de comprendre la distinction. Les erreurs simples résultent souvent de données d'entraînement incorrectes ou d'une mauvaise interprétation des entrées de l'utilisateur. Par exemple, si une IA est formée avec des données historiques incorrectes, elle produira des faits historiques incorrects. Il ne s'agit pas d'hallucinations mais plutôt de reflets de données défectueuses.

En revanche, les hallucinations sont plus insidieuses. Elles se produisent lorsqu'une IA, manquant d'informations nécessaires, génère des réponses qui n'ont aucune base en réalité. Cela revient à ce que l'IA invente des faits pour combler les lacunes, souvent avec un niveau de confiance qui peut induire les utilisateurs en erreur. Ce phénomène peut être attribué à la manière dont les modèles d'IA sont formés et fonctionnent, s'appuyant fortement sur les motifs dans les données d'entraînement pour générer des réponses.

La nature des hallucinations de l'IA

Pour comprendre pourquoi les hallucinations se produisent, il est essentiel de se pencher sur le fonctionnement des modèles d'IA. Les LLM sont formés sur d'immenses ensembles de données contenant une large gamme d'informations. Ils apprennent à prédire le mot suivant dans une phrase en fonction du contexte fourni par les mots précédents. Ce processus est fondamentalement probabiliste, ce qui signifie que l'IA génère la continuation la plus probable d'un texte donné en fonction de ses données d'entraînement.

Cependant, cette approche a ses limites. Lorsque l'IA rencontre une requête qui dépasse la portée de ses données d'entraînement ou qui implique des informations ambiguës ou incomplètes, elle tente de générer une réponse plausible. Cela peut conduire l'IA à produire des résultats entièrement fabriqués mais présentés avec une confiance injustifiée.

Par exemple, une IA principalement formée sur des données concernant les pratiques juridiques modernes pourrait être interrogée sur un précédent juridique historique obscur. Sans informations pertinentes, l'IA pourrait créer un cas fictif qui semble plausible mais qui n'a aucune base en réalité. C'est une hallucination classique.

Partie 2 : Atténuer les hallucinations de l'IA

Maintenant que nous comprenons ce que sont les hallucinations de l'IA et pourquoi elles se produisent, explorons comment les atténuer. Assurer la fiabilité et l'exactitude des résultats générés par l'IA est essentiel, surtout à mesure que l'IA s'intègre davantage dans divers aspects de nos vies.

Génération augmentée par récupération (RAG)

L'une des approches les plus prometteuses pour atténuer les hallucinations de l'IA est la génération augmentée par récupération (RAG). Cette méthode consiste à utiliser une base de données vectorielle pour récupérer des documents pertinents en fonction de la requête d'entrée. Le LLM génère ensuite des réponses en utilisant à la fois la requête et les documents récupérés, ancrant efficacement sa production dans des données réelles et récupérables.

Par exemple, dans un contexte de santé, une IA utilisant RAG pourrait accéder à une vaste base de données de revues médicales pour fournir des recommandations de traitement précises et à jour. Cela réduit le risque que l'IA fabrique des protocoles de traitement et garantit que l'information est basée sur les recherches les plus récentes. RAG améliore non seulement l'exactitude des réponses de l'IA, mais renforce également sa capacité à gérer des requêtes complexes en lui fournissant une sorte de "mémoire à long terme". Cette approche garantit que les réponses de l'IA ne sont pas purement basées sur des suppositions probabilistes mais sont soutenues par des informations pertinentes et factuelles.

Techniques de raisonnement

Une autre stratégie efficace consiste à améliorer les capacités de raisonnement de l'IA. Des techniques comme l'incitation par chaîne de pensée permettent aux LLM de décomposer des problèmes complexes en étapes intermédiaires, améliorant ainsi l'exactitude de leurs réponses. En guidant l'IA à travers une séquence logique d'étapes, ces techniques l'aident à arriver à des conclusions plus fiables.

Considérez l'analogie d'un étudiant résolvant un problème de mathématiques. Au lieu de sauter directement à la réponse finale, l'étudiant travaille méthodiquement chaque étape, s'assurant que chaque partie de la solution est correcte. De même, l'IA peut être guidée pour raisonner à travers des problèmes, conduisant à des résultats plus précis et justifiables. Cette méthode aide l'IA non seulement à générer la réponse finale, mais aussi à expliquer les étapes suivies pour arriver à cette réponse, rendant le processus plus transparent et digne de confiance.

Requêtes itératives

Les requêtes itératives impliquent un agent IA jouant le rôle de médiateur entre le LLM et un système de vérification des faits. La réponse initiale générée par le LLM est examinée par le vérificateur de faits, qui valide le résultat. Si des erreurs sont trouvées, le vérificateur de faits fournit des retours, et le LLM affine sa réponse. Ce processus itératif se poursuit jusqu'à ce qu'une réponse satisfaisante et exacte soit obtenue.

En affinant continuellement les réponses de l'IA par le biais de requêtes itératives, le risque d'hallucinations peut être considérablement réduit. Ce processus garantit que chaque réponse est vérifiée et validée avant d'être finalisée, réduisant ainsi la probabilité d'erreurs et améliorant la qualité globale des résultats.

Systèmes de vérification des faits

Les vérificateurs de faits valident l'exactitude des informations en croisant plusieurs sources fiables. Dans le contexte des LLM, ils valident les productions du modèle avant de les présenter à l'utilisateur. Cette couche supplémentaire de contrôle aide à identifier et à corriger les hallucinations, améliorant la fiabilité du contenu généré par l'IA. Les systèmes de vérification des faits peuvent être intégrés dans le flux de travail de l'IA, agissant comme une sauvegarde en temps réel contre la propagation d'informations fausses.

Conclusion

Les hallucinations de l'IA représentent un défi important dans le développement et le déploiement des systèmes d'IA. En comprenant pourquoi et comment elles se produisent, et en employant diverses stratégies d'atténuation, nous pouvons améliorer l'exactitude et la fiabilité des productions de l'IA. Bien que l'IA ait un potentiel immense, il est crucial de rester vigilant et critique face à ses limitations, en veillant à ce que la touche humaine reste essentielle pour superviser et valider le rôle de l'IA dans nos vies.

En adoptant ces stratégies, nous pouvons exploiter la puissance de l'IA tout en nous protégeant contre ses pièges, conduisant à une intégration plus fiable et bénéfique de cette technologie dans divers secteurs. Comprendre les nuances entre les erreurs simples et les véritables hallucinations, et mettre en œuvre des techniques d'atténuation robustes, sera essentiel pour construire un avenir où l'IA est un partenaire fiable dans nos efforts.

Prêt à transformer votre service client ? Essayez Fireraven et découvrez la différence par vous-même. Essayez Fireraven maintenant.

Plus de nouvelles

Fireraven vient de remporter la catégorie sociale à la Venture Cup Denmark ! Cette victoire constitue pour nous une étape importante et nous garantit une place dans la prestigieuse University Startup World Cup.

Nous sommes ravis d'annoncer que Fireraven a rejoint le prestigieux incubateur Next AI !

Imaginez un monde où chaque interaction avec une entreprise semble personnelle, fluide et humaine. Imaginez que vous appelez votre banque et, au lieu de naviguer dans un labyrinthe d'invites automatisées, vous êtes accueilli par un assistant numérique qui comprend vos besoins uniques, se souvient de vos interactions précédentes et répond avec empathie et précision.